728x90

NL2SQL ( Natural Language to(2) SQL )

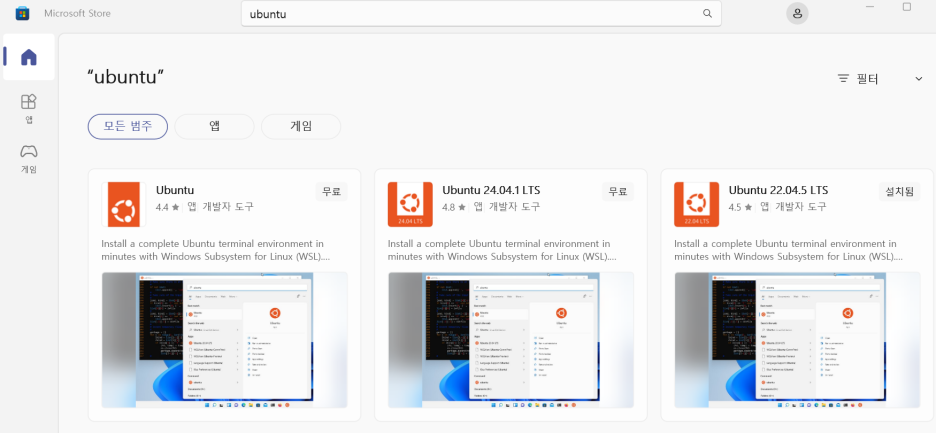

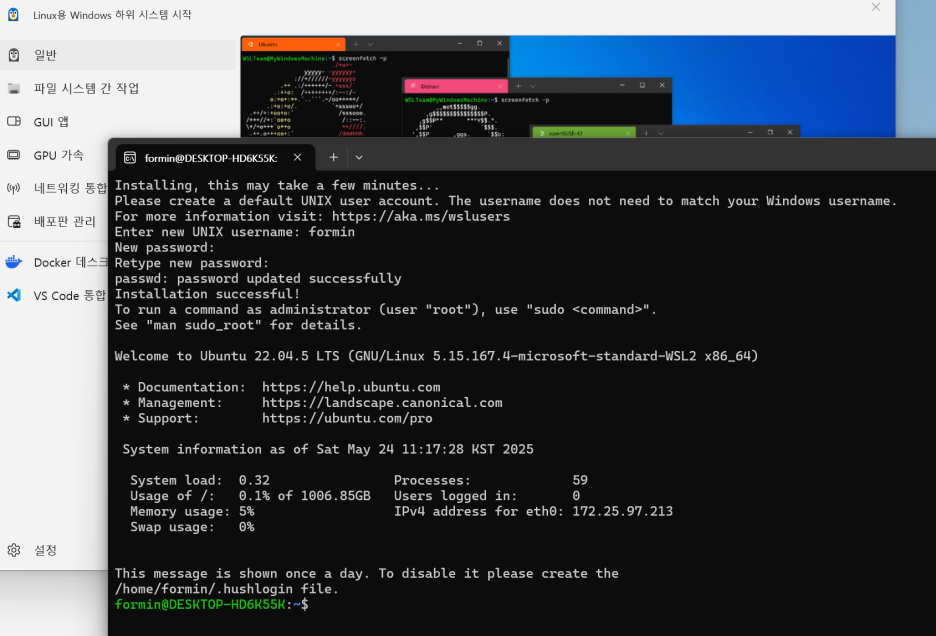

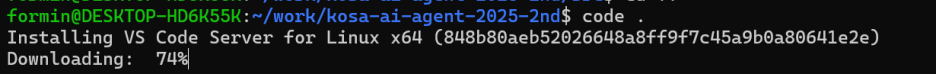

WSL2 ( Windows Subsystem for Linux2 )

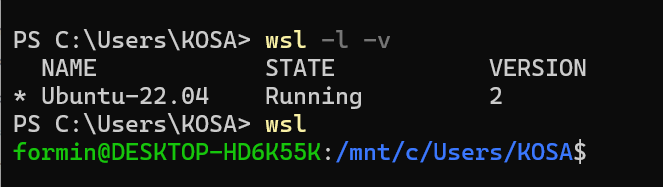

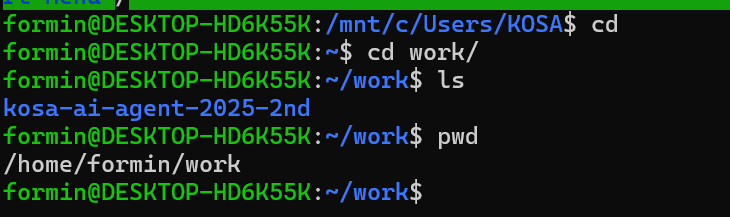

wsl -l -v

wsl -d Ubuntu-22.04

wsl

1) sudo apt-get update

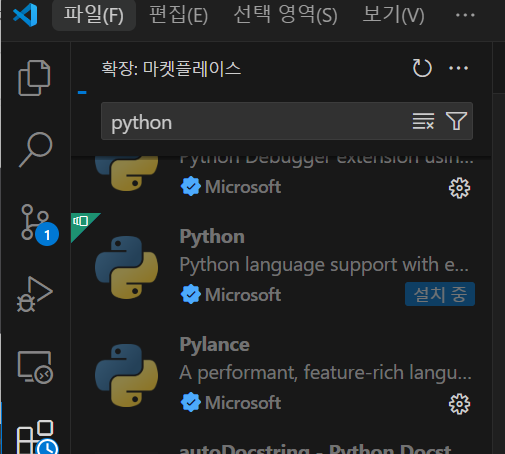

2) sudo apt-get install python3 python3-pip -y

728x90

AI Agent

-> LLM 이 외부 API 를 활용하는 것

-> functions vs tools ( server side 에서 관리 )

local LLM model

curl -fsSL https://ollama.com/install.sh | sh

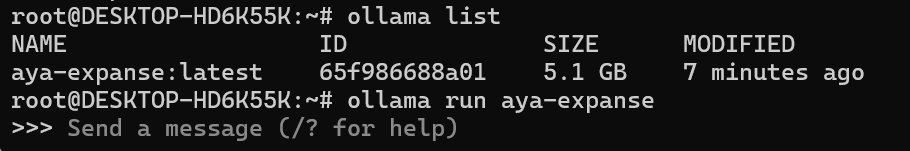

ollama ps

ollama pull aya-expanse

ollama list

ollama run aya-expane

# 2GB 스왑 파일 생성

sudo fallocate -l 2G /swapfile

sudo chmod 600 /swapfile

sudo mkswap /swapfile

sudo swapon /swapfile

# 적용 확인

free -h

nohup ollama run qwen3:0.6b > ollama_qwen3.log 2>&1 &

vi run_code_ollama.sh

./run

.wslconfig

[wsl2]

memory=4GB

swap=2GB # 스왑 공간 설정

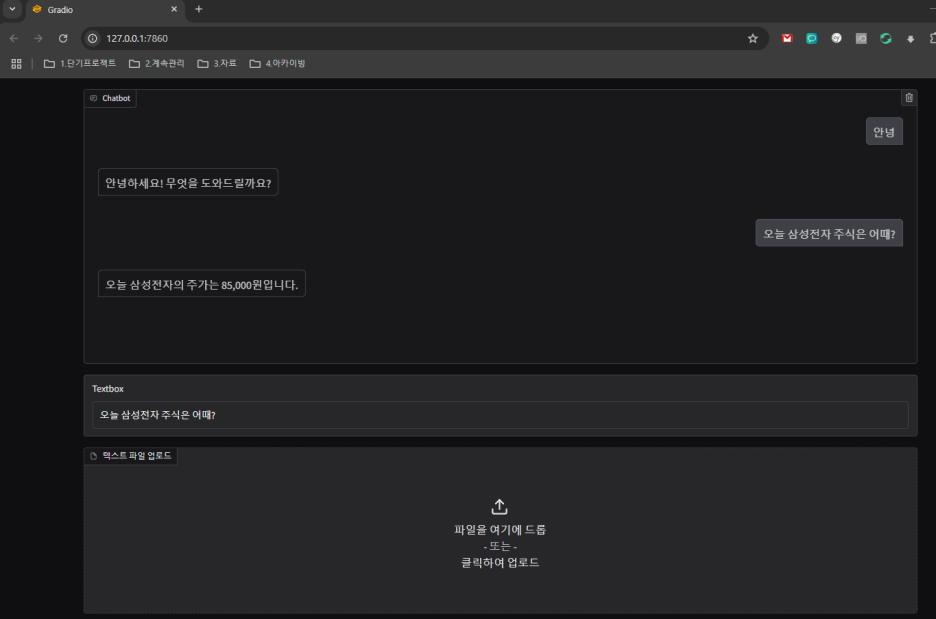

Gradio

pip install -U gradio

Streamlit

LangSmith

smith.langchain.com

728x90

'푸닥거리' 카테고리의 다른 글

| LLM 코드 보안의 새로운 접근법: AutoSafeCoder 소개 (0) | 2025.05.01 |

|---|---|

| ChatGPT와 IDE를 더 스마트하게 연결하는 MCP란? (0) | 2025.04.12 |

| 바이브 코딩(Vibe Coding)에 대하여 (0) | 2025.03.29 |

| Windows Hello 다른 계정에서 등록하는 방법 (0) | 2025.03.01 |

| 로컬 PC에서 오픈소스 LLM 모델 (DeepSeek) 실행하기 (0) | 2025.01.30 |

댓글